ChillStackは、自社サービスの開発に携わるエンジニアを対象に「AIガバナンスに関する実態調査」を実施し、200名から回答を得た結果を発表した。

また、一部の設問については情報システムや監査部署などガバナンスに関わる部署の担当者100名にも調査を行い、部門間での課題意識の違いを比較したとのことだ。

56%が自社サービスにAIを実装

自社サービス・システムへのAIの組み込み状況を尋ねたところ、「サービスの主要機能として組み込んでいる」が30.5%、「一部機能として組み込んでいる」が25.5%で、あわせて56.0%がすでにAIを組み込んでいることがわかったという(n=200/エンジニア)。

主要機能への適用も3割に達しており、企業がAIを本格的にサービスへ実装する段階へ進んでいる様子がうかがえるとのことだ。

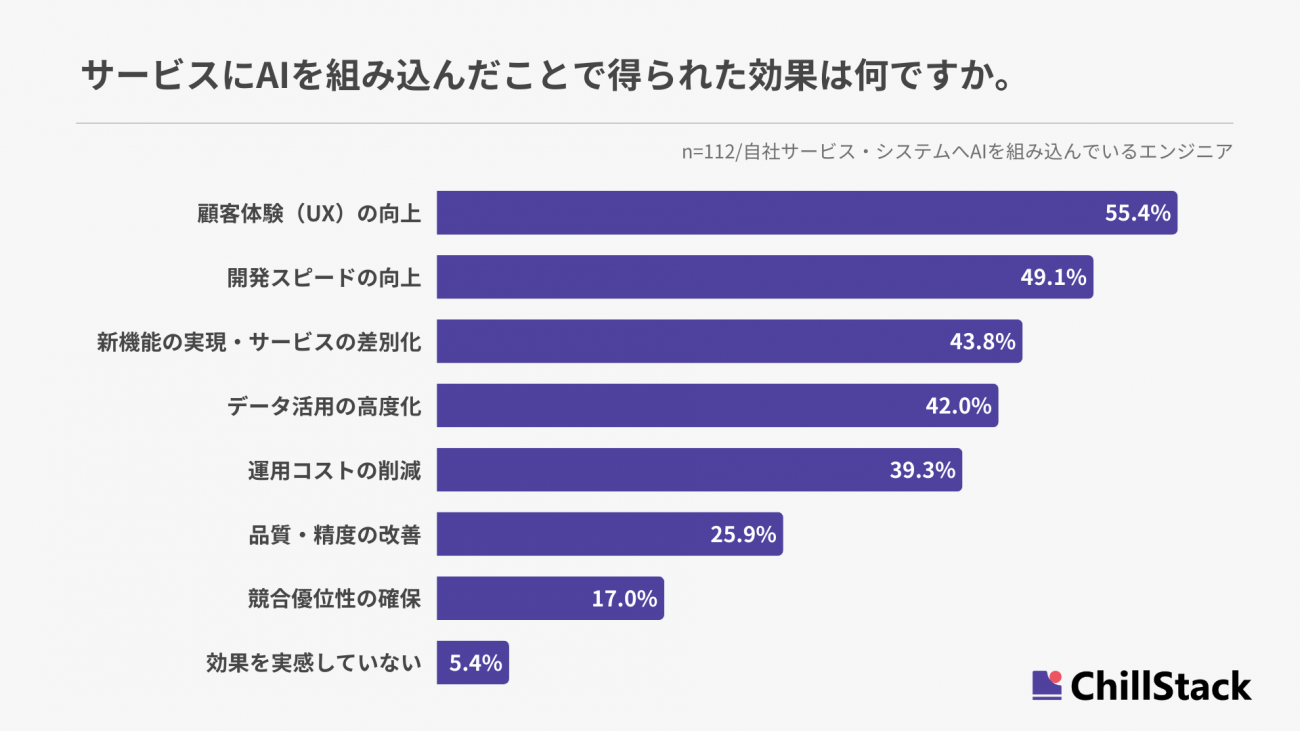

サービスへのAI実装による効果

AIを自社サービス・システムに組み込んだことで得られた効果を尋ねたところ、「顧客体験の向上」が55.4%で最も多く、「開発スピードの向上」が49.1%、「新機能実現・サービス差別化」が43.8%と続いた(n=112/自社サービス・システムへAIを組み込んでいるエンジニア)。データ活用の高度化や運用コスト削減といった効果も見られたという。

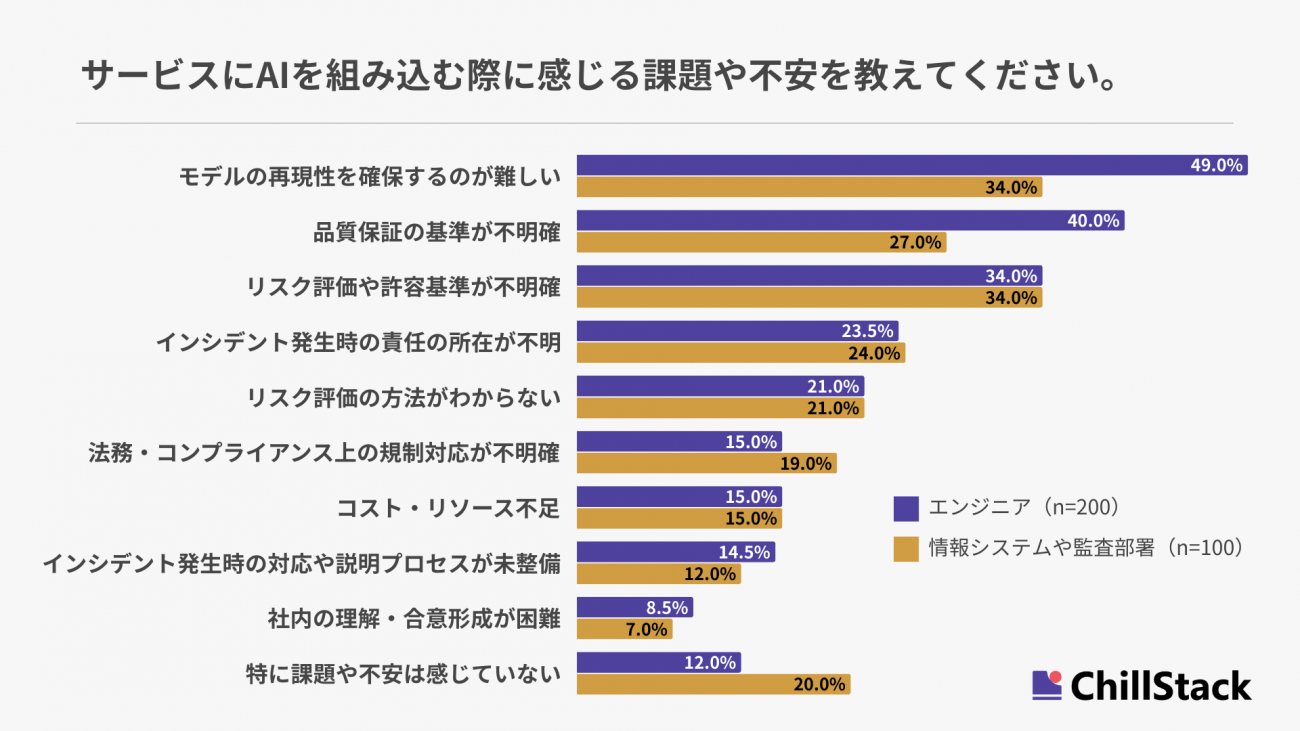

エンジニアは技術的課題を、情シス・監査はリスク管理を強く懸念

AIを自社サービス・システムに組み込む際の課題・不安を尋ねたところ、エンジニアは「モデルの再現性確保の難しさ」が49.0%で最も多く、「品質保証の基準が不明確」が40.0%、「リスク評価や許容基準の不明確さ」が34.0%と続いた(n=200/エンジニア)。

一方、情報システムや監査部署の回答を見ると、「モデルの再現性確保の難しさ」と「リスク評価・許容基準の不明確さ」がともに34.0%、「品質保証の基準が不明確」が27.0%だったという(n=100/情報システムや監査部署)。

両部門を比較すると、いずれも「リスク評価・許容基準の不明確さ」や「インシデント発生時の責任の所在」といったリスク関連の項目を共通して大きな懸念として捉えていることがわかる。

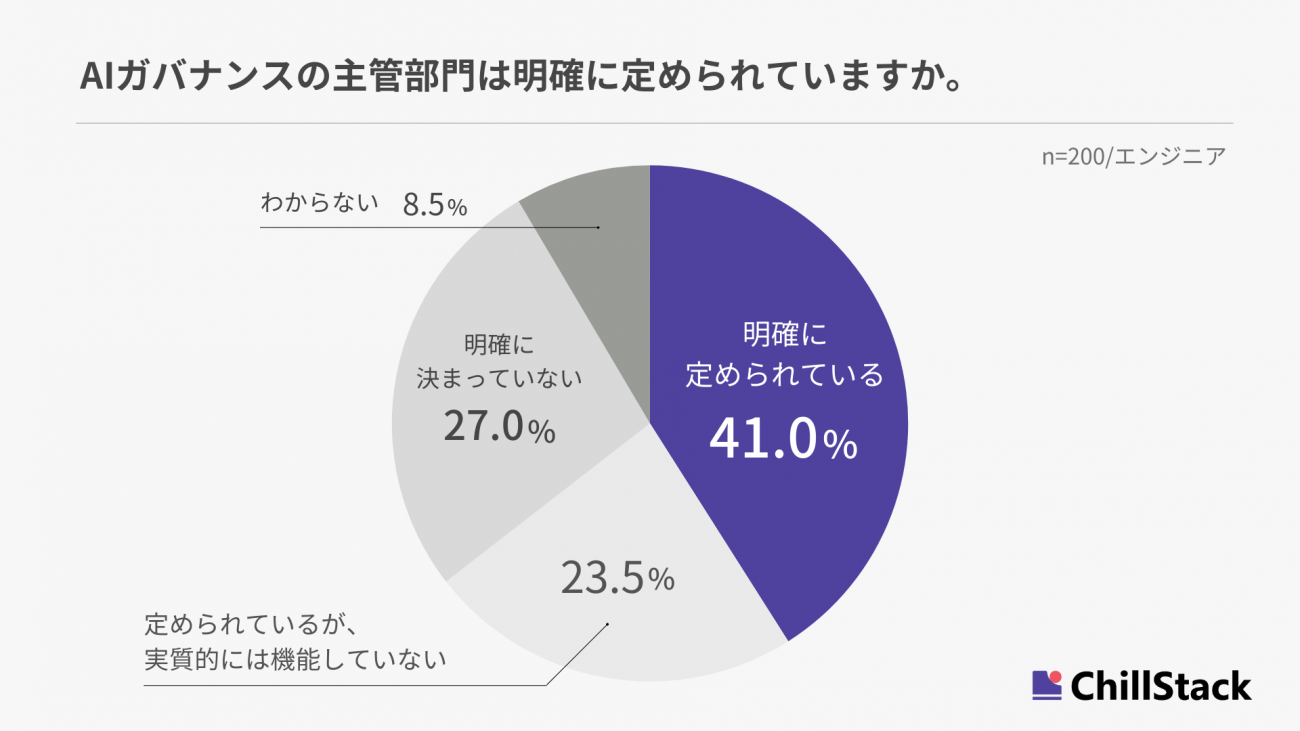

半数以上の企業で、AIガバナンスの主管部門が「不在・機能不全」

AIガバナンスの主管部門が明確に定められているか尋ねたところ、「定められているが機能していない」が23.5%、「明確に決まっていない」が27.0%で、合わせて50.5%の企業でAIガバナンス体制が未整備または形骸化している実態が浮き彫りになったとしている(n=200/エンジニア)。

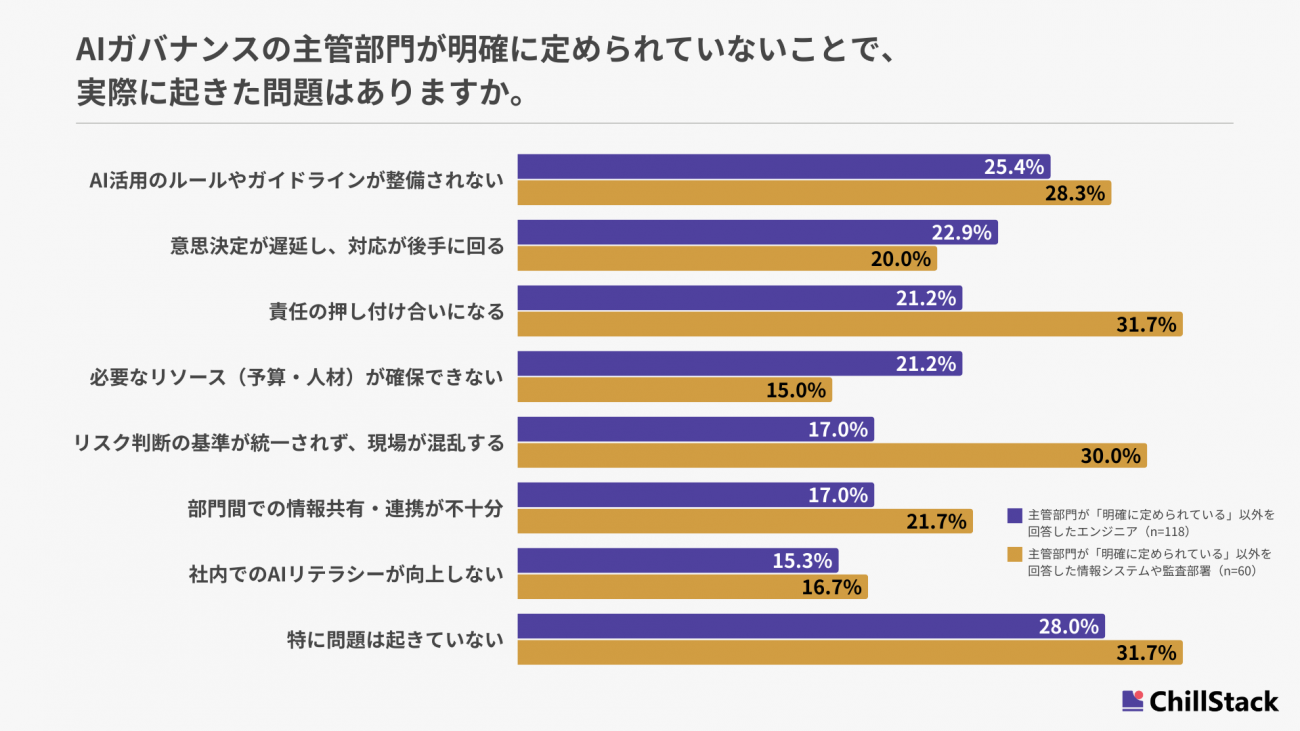

主管部門の不在でエンジニアは「ルール未整備」、情シス・監査は「責任の押し付け合い」を問題視

AIガバナンスの主管部門が明確に定められていない企業のうち、「特に問題は起きていない」と回答したのは、エンジニアで28.0%、情報システムや監査部署で31.7%という結果に。主管部門が未整備・機能不全の企業においては、約7割で既に何かしらの問題が起きている実態が明らかになったという。

そのうえで、主管部門が明確に定められていないことで実際に起きた問題を尋ねたところ、エンジニアは「AI活用のルールやガイドラインが整備されない」が25.4%で最も多く、「意思決定が遅延し、対応が後手に回る」が22.9%、「責任の押し付け合いになる」が21.2%と続いた(n=118/主管部門が「明確に定められている」以外を回答したエンジニア)。

一方、情報システムや監査部署の回答を見ると、「責任の押し付け合いになる」が31.7%で最も多く、「リスク判断の基準が統一されず、現場が混乱する」が30.0%、「AI活用のルールやガイドラインが整備されない」が28.3%と続いた(n=60/主管部門が「明確に定められている」以外を回答した情報システムや監査部署)。

両部門の回答を比較すると、AI実装を担うエンジニアは「指針や基準がないこと」を主な問題として挙げる一方、情報システムや監査部署はインシデント発生後のリスク対応に関わる問題をより深刻に捉えていることが明らかになったとのことだ。

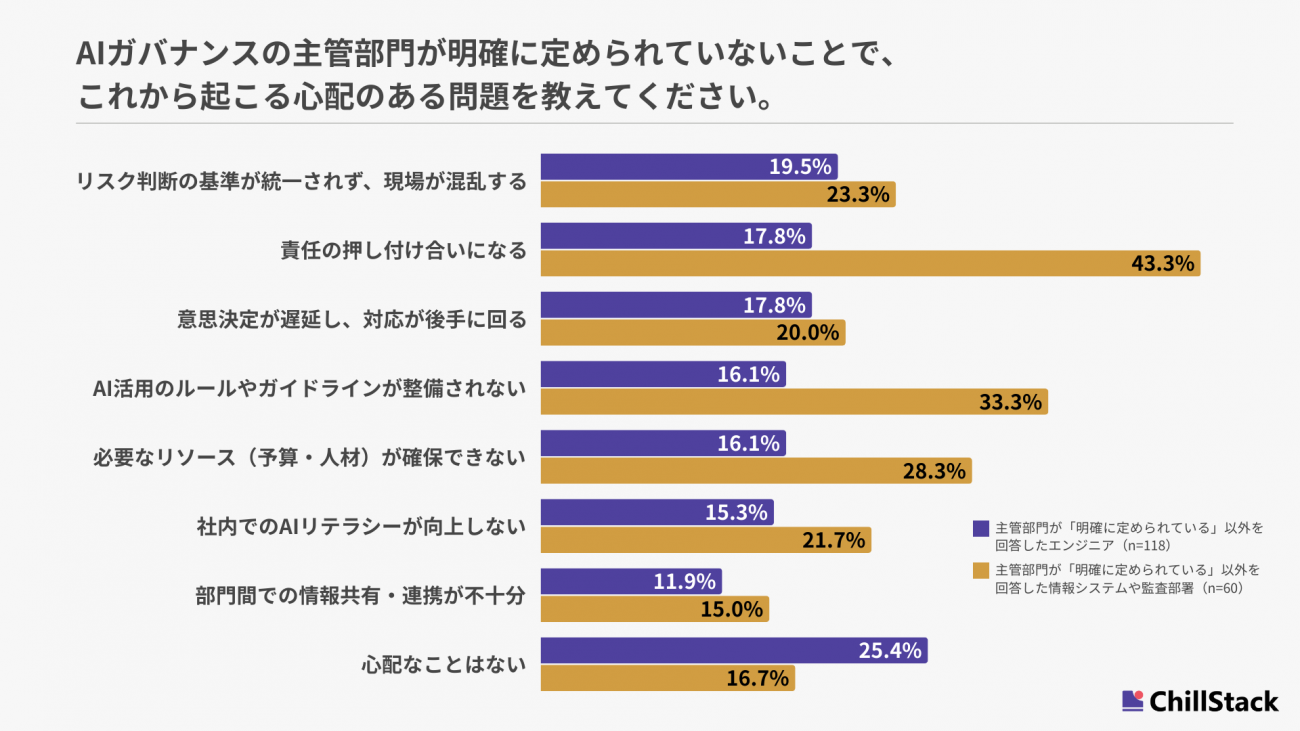

将来のリスク、情シス・監査部署の43.3%が「責任の押し付け合い」を懸念

AIガバナンスの主管部門が明確に定められていないことで、今後起こり得る問題を尋ねたところ、エンジニアは「リスク判断の基準が統一されず、現場が混乱する」が19.5%で最も多く、「責任の押し付け合いになる」が17.8%、「意思決定が遅延し、対応が後手に回る」が17.8%と続いた(n=118/主管部門が「明確に定められている」以外を回答したエンジニア)。

一方、情報システムや監査部署の回答を見ると、「責任の押し付け合いになる」が43.3%と突出して高く、「AI活用のルールやガイドラインが整備されない」が33.3%、「必要なリソース(予算・人材)が確保できない」が28.3%と続いた(n=60/主管部門が「明確に定められている」以外を回答した情報システムや監査部署)。

なお、「心配なことはない」と回答した割合は、エンジニアが25.4%だったのに対し、情報システムや監査部署は16.7%だった。

これらの結果から、エンジニアは現場での基準・ルール不在による混乱を懸念している一方で、情報システムや監査部署は、責任の所在やガバナンス不備といった組織・リスク面の影響を、より重いリスクとして捉えていることが明らかになったとしている。

約半数がAIインシデント対応フローが機能せず

AIに起因するインシデントが発生した際の対応フローが整備されているか尋ねたところ、「整備されており、機能している」が54.5%で最も多く、「整備されているが、実質的には機能していない」が18.8%、「整備されていない」が13.4%と続いた(n=112/自社サービス・システムへのAIを組み込んでいる企業のエンジニア)。

約5割の企業では、AIインシデント発生時の対応フローが未整備または形骸化しており、リスク対応が遅れる可能性があることがうかがえるという。

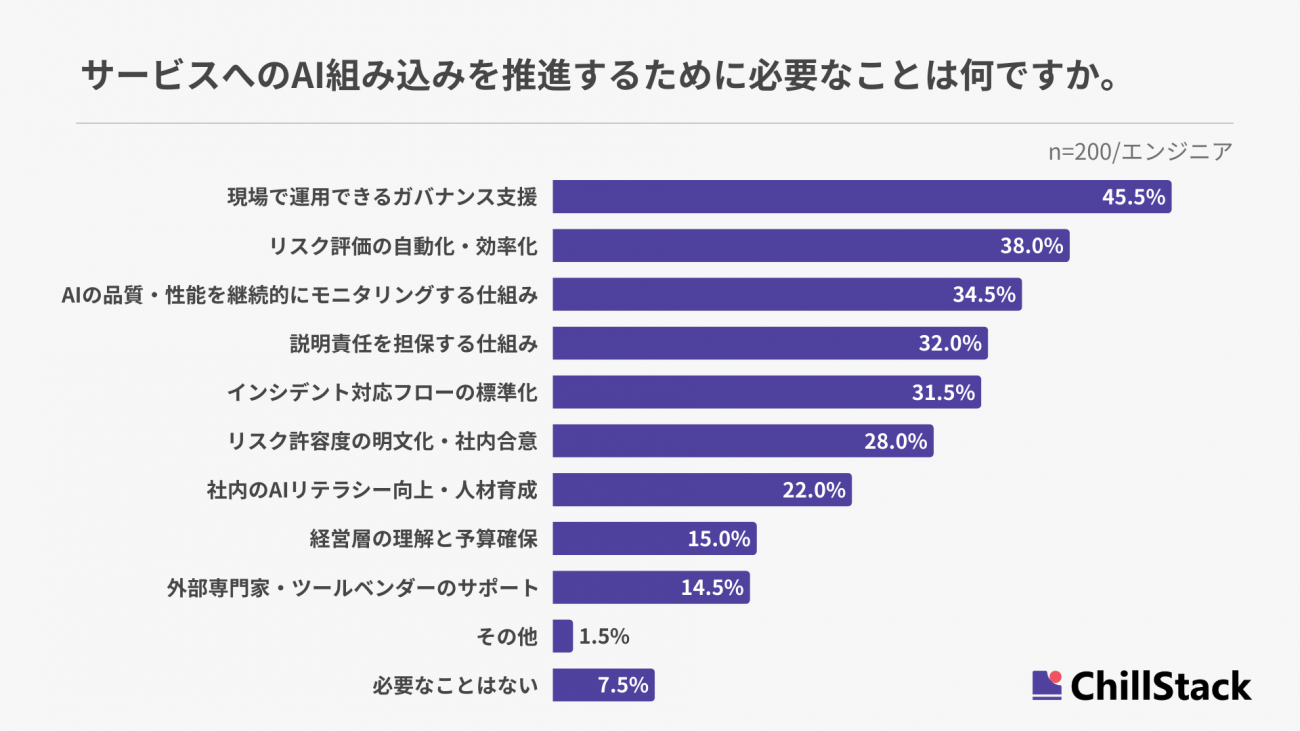

AI推進に必要なものは「現場で運用できるガバナンス支援」

AI組み込みを推進するうえで必要なことを尋ねたところ、「現場で運用できるガバナンス支援」が45.5%で最も多く、「リスク評価の自動化・効率化」が38.0%、「品質モニタリング」が34.5%と続いた(n=200/エンジニア)。

調査概要

- 調査名称:AIガバナンスに関する実態調査

- 調査機関:Freeasy

- 調査対象:自社サービスの開発に携わるエンジニア/情報システムや監査部署などガバナンスに関わる部署の担当者

- 調査方法:Webアンケート

- 調査期間:2025年11月28日~30日

- 有効回答数:エンジニア200件、ガバナンスに関わる部署の担当者100名

この記事は参考になりましたか?

- 関連リンク

- この記事の著者

-

EnterpriseZine編集部(エンタープライズジン ヘンシュウブ)

「EnterpriseZine」(エンタープライズジン)は、翔泳社が運営する企業のIT活用とビジネス成長を支援するITリーダー向け専門メディアです。データテクノロジー/情報セキュリティの最新動向を中心に、企業ITに関する多様な情報をお届けしています。

※プロフィールは、執筆時点、または直近の記事の寄稿時点での内容です

この記事は参考になりましたか?

この記事をシェア