近年、HCI(ハイパーコンバージドインフラストラクチャ)が普及しつつあるが、拡張性、遅延、バックアップなどで課題も浮かびあがってきた。そうした課題を解決するものとして生まれたのがデイトリウム社の「Datrium DVX」。ネットアップやデータドメインでバックアップ製品を手がけてきたデイトリウム社チーフサイエンティストのヒューゴ・パターソン氏が解説する。

高性能を求めて進化してきたHCI、しかし課題も浮上

「ここ十数年、技術が次々と進化を遂げていて、とてもエキサイティングな時代です。ハードウェア、仮想化、クラウドをどのように組み合わせるか、どれが正しいアーキテクチャなのか模索が続いています」

米デイトリウム チーフサイエンティスト ヒューゴ・パターソン氏

そう語るのはヒューゴ・パターソン氏。米国デイトリウム社のチーフサイエンティストであり、創業者の1人でもある。過去にはネットアップ、データドメインのチーフ・アーキテクトおよびCTO、EMC(当時)のバックアップ・リカバリ・システム部門のCTOおよびフェローを務めたことがある。取得した特許は119件にのぼる。

パターソン氏が特に強い専門領域はバックアップ。ネットアップ時代はバックアップの課題に取り組んでいて、バックアップにスナップショットを活用する製品を開発した。またデータドメインでは業界で初めて重複排除できるストレージシステムを構築した。

現在はHCI(ハイパーコンバージドインフラストラクチャ)を提供するデイトリウムに在籍している。これまでのCIおよびHCIの流れと、同社が提供する新しい発想で開発されたHCIについて解説する。

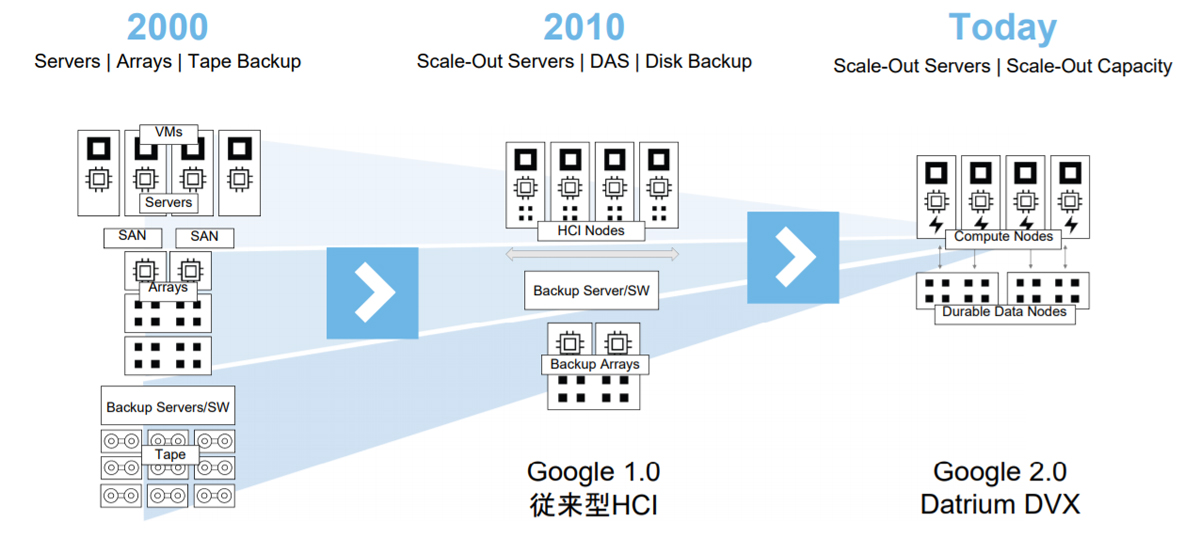

まずはCIやHCIがどのように進化してきたのか。2000年ごろはまだサーバーとストレージは分かれていた。ストレージはSANでディスクアレイを構成し、バックアップはテープに記録していたという具合だ。

2010年ごろになると、Googleが新しいアーキテクチャを考案した。パターソン氏によると、これがHCIとしては最初のジェネレーションとなるそうだ。サーバーとストレージを一体化して、HCIのノードとし、バックアップはバックアップ専用のアレイに記録する。細かな進化はありつつも、これが現状のHCIの基本形となっている。

プライベートクラウドはハイパースケーラーとともに進化 出所:デイトリウム[画像クリックで拡大表示]

しかしHCIが普及するにつれ、サーバーとストレージを一緒にする弊害が浮かびあがってきた。「(当時としては)理想的だったのですけどね」とパターソン氏は言う。

従来型HCIの課題は主に3つ。拡張時のレイテンシー、バックアップ、DR(災害対策)でクラウドを使用する時の複雑さとコストだ。

拡張性とレイテンシーついて、もう少し詳しく見ていこう。HCIは仮想サーバー、I/Oプロセッシング、データを一体化したため、コンピューティングとストレージを別々に拡張しづらい。どちらかを増やそうとすると、(要らなかったとしても)もう片方も増やさざるをえない。またサーバーベンダーや仕様で制約をうけることもある。例えばGPUを強化したくても、ベンダーが多数のGPUを搭載した製品を提供していないことも起こりうる(最近では多数のGPUやFPGAを搭載可能な製品も登場しつつあるが)。また多数のノードに拡張すると、ネットワーク遅延が目立つようになる。クリティカルで低遅延が求められるワークロードでは問題となる。

バックアップにも課題がある。一般的にHCIにはバックアップまではコンバージドされていない。つまり別途用意する必要がある。ただしHCIのバックアップとなると、高コストになりがちだ。バックアップ製品をどれにするか、どう運用していくかも見積もる必要がある。

また近年ではバックアップ先としてクラウドのストレージを採用するケースも増えてきている。可能ではあるものの、パターソン氏は「複雑で(データ量が多ければ)コストがかかります」と指摘する。クラウドのストレージサービスは手軽に利用できて安価というイメージがあるものの、従量課金なので企業が保有するようなデータ規模となると使用料金がつり上がるためだ。

この記事は参考になりましたか?

- この記事の著者

-

加山 恵美(カヤマ エミ)

EnterpriseZine/Security Online キュレーターフリーランスライター。茨城大学理学部卒。金融機関のシステム子会社でシステムエンジニアを経験した後にIT系のライターとして独立。エンジニア視点で記事を提供していきたい。EnterpriseZine/DB Online の取材・記事も担当しています。Webサイト:https://emiekayama.net

※プロフィールは、執筆時点、または直近の記事の寄稿時点での内容です

この記事は参考になりましたか?

この記事をシェア